AI Ethiek

Bouw AI-oplossingen die eerlijk, transparant en mensgericht zijn.

Bouw AI-oplossingen die eerlijk, transparant en mensgericht zijn.

AI is een krachtig hulpmiddel, maar de ontwikkeling ervan brengt een grote verantwoordelijkheid met zich mee. De data die we gebruiken is geen abstractie; het vertegenwoordigt vaak mensen, hun gedrag, hun voorkeuren en hun levens.

Ons ethisch kompas is daarom helder: we willen AI-oplossingen maken waar mensen vrolijk van worden, echt iedereen. Dit geldt ook, en misschien wel juist, voor de mensen wiens data de basis van het model vormen. Ethiek is voor ons geen 'vinkje' achteraf, maar een fundamenteel onderdeel van het ontwerpproces.

Maar daarbij moeten we ook eerlijk zijn: een model dat volledig vrij is van 'bias' (vooringenomenheid) is een utopie. De kern van machine learning is patroonherkenning en onderscheid maken. Een model dat honden van katten onderscheidt, 'discrimineert' op basis van kenmerken als snuitlengte of oren. Dit is functioneel en gewenst.

Het wordt complexer wanneer die kenmerken mensen betreffen. De data die we gebruiken is een spiegel van onze maatschappij, inclusief de historische en systemische vooroordelen die daarin verweven zijn.

De cruciale ethische vraag is daarom niet óf een model onderscheid maakt, maar:

Ben jij klaar om AI verantwoord in te zetten binnen jouw organisatie?

AI-modellen baseren hun resultaten uitsluitend op de data die de ontwikkelaars aan ze geven. Dit is per definitie een onvolledige digitale representatie van de complexe, analoge werkelijkheid. Er zijn vele verschillende soorten bias, die op meerdere manieren in het proces kunnen sluipen. Twee van de meest voorkomende en impactvolle vormen zijn:

Een veelgehoorde misvatting is:

"Als we gevoelige kenmerken zoals etniciteit of geslacht uit de dataset verwijderen, kan het model daar niet op discrimineren."

Dit is helaas onjuist.

Modellen zijn waanzinnig goed in het vinden van correlaties. Dit kan leiden tot proxy-discriminatie: het model gebruikt datapunten die neutraal lijken (zogenaamde 'proxy-variabelen'), maar die sterk samenhangen met een gevoelig kenmerk dat het model in feite alsnog op dat kenmerk discrimineert.

Enkele voorbeelkden zijn:

Een model dat leert dat 'postcode X' een hoog risico vormt, discrimineert mogelijk indirect op basis van afkomst of religie, zelfs als die data 'netjes' was verwijderd. Het waarborgen van de privacy van gevoelige gegevens alleen is daarom niet voldoende om te garanderen dat een model niet vooringenomen is. Sterker nog, dit kan het zelfs moeilijker maken om te herkennen óf dat zo is.

Afhankelijk van hoe je de uitkomst van een AI model inzet, bestaat ook nog het risico dat het onbewust in een feedback-loop terechtkomt die deze vooringenomenheid nog verder uitvergroot. Dit kan gebeuren wanneer er sprake is van een zelfvervullende voorspelling, een self-fulfilling prophecy.

Een voorbeeld: je bent op zoek naar fraudegevallen en zet AI in om te bepalen waar controles uitgevoerd moeten worden. Het model stuurt je naar specifieke gebieden. Omdat je voornamelijk daar controleert, vind je logischerwijs ook alleen daar fraudegevallen.

Deze 'vondsten' dienen als input voor de nieuwe versie van het model. Het model leert hiervan en zal je daardoor met nóg meer overtuiging naar diezelfde gebieden sturen. Hierdoor wordt de oorspronkelijke vooringenomenheid 'bevestigd' en alleen maar versterkt.

Een AI-systeem neemt geen beslissingen, het doet statistische voorspellingen. Een algoritme kan niet verantwoordelijk worden gehouden voor de impact van een keuze. De eindverantwoordelijkheid ligt daarom altijd bij de mens: de ontwikkelaar, de organisatie die het implementeert en de eindgebruiker die op basis van de output handelt.

We moeten AI zien als een hulpmiddel dat de mens ondersteunt en adviseert. Het 'human-in-the-loop'-principe is essentieel, zeker bij beslissingen met een hoge impact (zoals zorg, financiën of justitie). De Europese AI Act voorziet in richtlijnen toegespits op de verschillende risico-categorieën van AI-toepassingen. Dit is ook ons uitgangspunt: de mate van controle en transparantie moet in verhouding staan tot de impact van de applicatie. Een model dat helpt bij het sorteren van e-mail (laag risico) vraagt om een ander niveau van toezicht dan een model dat beslissingen in de zorg of justitie ondersteunt (hoog risico). Om die menselijke controle mogelijk te maken, is transparantie cruciaal. We moeten kunnen begrijpen waarom een model tot een bepaalde aanbeveling komt. Dit is het domein van Explainable AI (XAI). Alleen als we de redenering van een model kunnen volgen, kunnen we controleren of het de juiste (ethische) afwegingen maakt en ingrijpen als dat niet zo is.

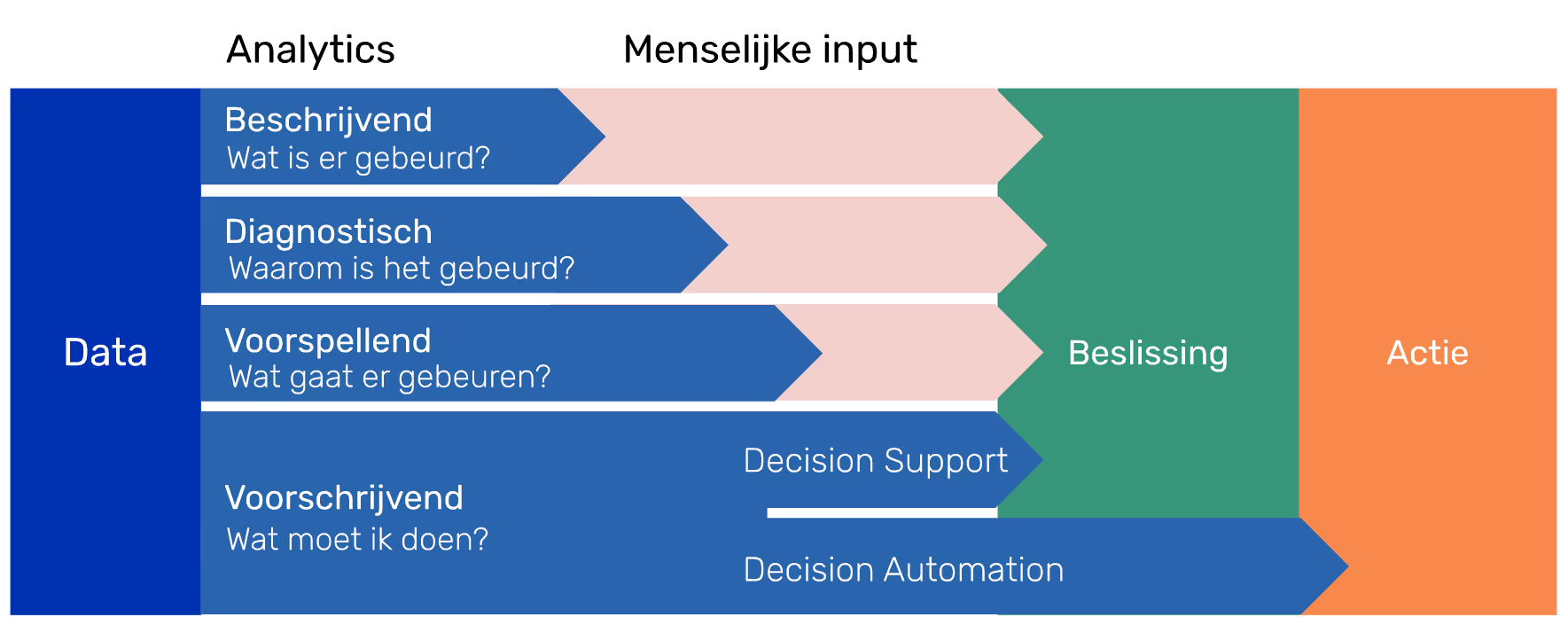

Afhankelijk van de toepassing en het risicoprofiel, geloven wij erg in Decision Support waarbij AI als ondersteuning wordt toegepast.

Voordat een AI-systeem wordt gebouwd of geïmplementeerd, is het essentieel om de risico's in kaart te brengen.

Ethiek moet vanaf de eerste dag worden ingebouwd ('Ethics by Design'). Wij bieden praktische begeleiding om uw ethische principes te vertalen naar de werkvloer.

Dit omvat hulp bij:

Heeft u al AI-systemen in productie? De wereld verandert, data verandert, en uw model verandert mee. Wat gisteren eerlijk leek, kan vandaag voor onverwachte problemen zorgen ('model drift').

Wij voeren onafhankelijke ethische checks uit op bestaande systemen:

Neem vrijblijvend contact met ons op!